Gemma的故事

2024-12-25 11:43:51 34

Gemma介绍

Gemma是由谷歌DeepMind及其他相关团队共同开发的系列轻量级AI模型,采用与Gemini模型相同的技术,专为帮助开发者和研究人员构建负责任的人工智能应用而设计。该系列包括两种规模的模型:Gemma 2B和Gemma 7B,提供了预训练和指令微调版本,支持JAX、PyTorch及TensorFlow等多个框架,以确保在不同设备上的高效运行。

Gemma的官方资源

- Gemma官网主页:https://ai.google.dev/gemma?hl=zh-cn

- Gemma的Hugging Face模型:https://huggingface.co/models?search=google/gemma

- Gemma的Kaggle模型地址:https://www.kaggle.com/models/google/gemma/code/

- Gemma的技术报告:https://storage.googleapis.com/deepmind-media/gemma/gemma-report.pdf

- 官方PyTorch实现GitHub代码库:https://github.com/google/gemma_pytorch

- Gemma的Google Colab运行地址:https://colab.research.google.com/github/google/generative-ai-docs/blob/main/site/en/gemma/docs/lora_tuning.ipynb

Gemma的核心特点

- 轻量级设计:Gemma模型为轻量级架构,适合在各类计算环境中部署,涵盖从个人电脑到高性能工作站的广泛设备。

- 开放源码:Gemma的权重开放,允许在遵守相关许可的情况下,进行商业化使用及分发。

- 预训练与微调:Gemma提供预训练版本及经过指令微调的版本,后者通过人类反馈强化学习(RLHF)确保模型的行为更加负责任。

- 支持多种框架:Gemma支持包括JAX、PyTorch、TensorFlow等主流AI框架,利用Keras 3.0工具链,简化了推理和监督微调(SFT)过程。

- 安全性保障:在开发过程中,Gemma遵循Google的AI伦理原则,使用自动化技术清理训练数据中的敏感信息,并进行严格的安全评估,如红队测试和对抗性测试。

- 优化性能:Gemma模型针对NVIDIA GPU和Google Cloud TPUs等硬件进行了优化,确保在多种设备上都能实现高效能。

- 社区支持:Google为开发者和研究人员提供免费的Kaggle、Colab资源,以及Google Cloud积分,鼓励创新和研究。

- 跨设备兼容:Gemma支持在各类设备上运行,从笔记本、台式机到物联网设备和云端,适配多种AI应用。

- 负责任的AI工具包:Google推出了Responsible Generative AI Toolkit,帮助开发者构建安全且负责任的AI应用,包含安全分类器、调试工具及相关指南。

Gemma的技术细节

- 模型架构:Gemma基于Transformer解码器架构,这是当前自然语言处理(NLP)领域最先进的模型之一。它采用多头注意力机制,能够在处理文本时聚焦于多个部分。此外,Gemma使用旋转位置嵌入(RoPE)替代传统的绝对位置嵌入,提升效率并减小模型体积。GeGLU激活函数取代了标准的ReLU非线性激活,同时每个Transformer子层的输入和输出都进行了归一化处理。

- 训练设施:Gemma模型在Google的TPUv5e上进行训练,这是专为机器学习设计的高效计算平台。模型通过在多个Pod(芯片集群)上分片和复制数据,极大地提高了分布式计算资源的利用效率。

- 预训练数据:Gemma模型在大量英语数据上进行预训练,其中2B版本使用了大约2万亿个token的数据,而7B版本使用了6万亿个token的数据,数据来源包括网络文档、数学问题和代码。所有数据都经过过滤,以减少不合适或不安全内容的影响,同时保证数据的多样性和质量。

- 微调方法:Gemma通过监督式微调(SFT)和基于人类反馈的强化学习(RLHF)进行微调,使用合成文本对和人类生成的提示响应对,并通过人类偏好数据训练奖励模型。

- 安全与责任:Gemma的设计特别关注安全性和责任,预训练阶段对数据进行了过滤,避免了敏感信息和不良内容的产生。此外,Gemma还通过了多个安全性评估,包括自动化基准测试和人工评估,以确保在实际使用中的安全性。

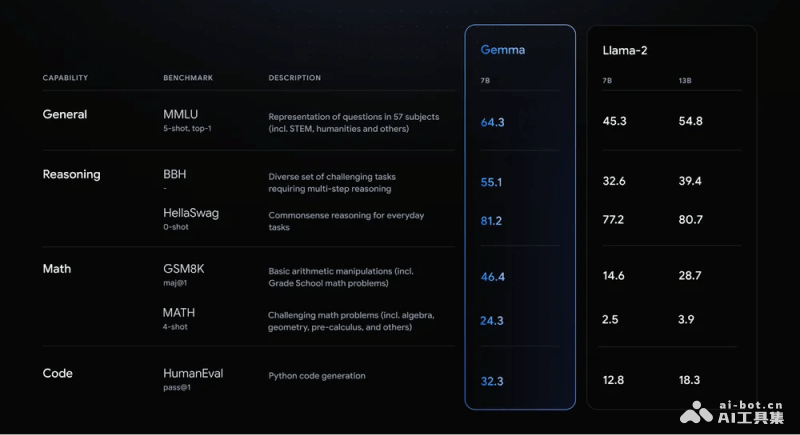

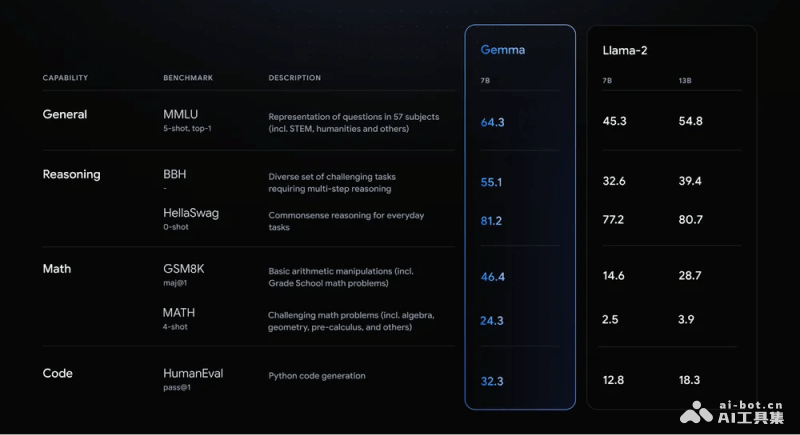

- 性能评估:Gemma在多个领域进行了广泛的性能测试,包括问答、常识推理、数学与科学解题以及编程任务。与同等规模或更大规模的开放模型对比,Gemma在多个基准测试中表现优异,尤其是在MMLU、MBPP等18个基准中,11个测试的结果超过了Llama-13B或Mistral-7B等模型。

- 开源与可用性:Gemma模型以开源形式发布,提供了预训练和微调后的检查点以及推理和部署的开源代码。这使得研究人员和开发者能够充分利用这些先进的语言模型,推动AI领域的进一步发展。

常见问题解答

Gemma一词意味着什么?

本文转载自互联网,如有侵权,联系 478266466@qq.com 删除。